一連のBXTによる再画像処理の4例目です。これまで以下のように3つの再処理例を記事にしてきました。

元々BXTで言われていた星雲部分の分解能、あまり話題になってなくて遥かに期待以上だった恒星の収差補正など、劇的な効果があります。

その一方、最近のM106の画像処理で分かったのは

M106も2度処理しているのである意味再処理なのですが、BXTを使っての「過去画像の」再処理という意味では、銀河を扱うのは今回初めてになります。これまで手をつけなかったことには実は明確な理由がありますが、そこらへんも記事に書いておきました。

そう言ったことも踏まえて、今回のBXTを使った処理では何が分かったのでしょうか?

ターゲットのM51: 子持ち銀河ですが、昨年4月に自宅でSCA260を使い、ASI294MM ProのRGB撮影で総露光時間4時間半で撮影したものです。

実はM51の再処理、かなり初期の頃に手掛けています。時期的は最初のBXTでの再処理の最初の記事の三日月星雲よりも前に試しています。銀河はBXTで分解能が上がることをかなり期待していました。でも改善がほとんど見られなかったのです。

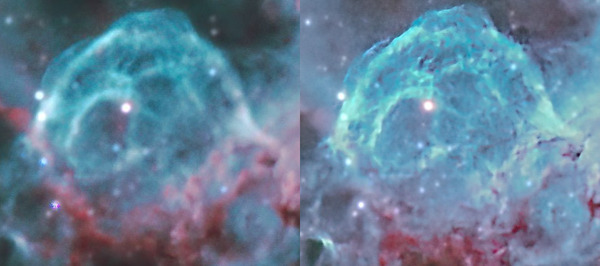

BTX導入直後くらいに一度M51の再処理を試み、その後三日月星雲とかを処理してある程度技術的にも確立してきた後に、さらに再処理してみたM51です。

同じ画角の元の画像を下に載せます。

再処理ではHαを載せていないので、派手さはないのは無視してください。2つを比較してみると、確かに少し分解能は上がったかもしれません。でも思ったほどの改善ではありませんし、むしろノイジーになるなど、悪くなっているところも見受けられます。なんでか色々考えたのですが、恐らくですが以前の処理はDeNoise AIを利用するなどかなり頑張っていて、すでにそこそこの解像度が出ていたということです。言い換えると、(今のところの結論ですが)いくらAIと言えど、画像に含まれていない情報を引き出すことは(例え処理エンジンは違っても)できないのではということです。逆に情報として含まれていないものを飛び抜けて出したとしたら、それは流石にフェイクということになります。

BTXとDeNoise AIを比べてみると、DeNoise AIの方が(天体に特化していないせいか)大きくパラメータを変えることができるので、おかしくなるように見えると思われがちですが、おかしくならない程度に適用する分には、BXTもDeNoise AIもそこまで差がないように思いました。DeNoise AIはノイズ除去と共にSharpen効果もあるのですが、BXTはノイズについてはいじることはないので、DeNoise AI = NoiseXTerminator + BlurXTerminatorという感じです。

それでは、DeNoise AIではなくBlurXTerminatorを使う利点はどこにあるのでしょうか?最も違うところは、恒星の扱いでしょう。DeNoise AIは恒星ありの画像は確実に恒星を劣化させるので、背景のみにしか適用できないと思っていいでしょう。その一方、BlurXTerminatorはAIと言っても流石にdeconvolutioinがベースなだけあります。星像を小さくする効果、歪みをかなりのレベルで補正してくれる効果は、BlurXTerminatorの独壇場です。恒星を分離した背景のみ、もしくは恒星をマスクした背景のみの構造出しならDeNosie AIでもよく、むしろノイズも同時に除去してくれるので時には便利ですが、やはり恒星をそのままに背景の処理をできるBXTとNXTの方が手間が少なく恒星のダメージも全然少ないため、天体写真の処理に関して言えばもうDeNoise AIを使うことはほとんどなくなるのかと思います。

さて、上の結果を見るとこのままの状態でBXTを使ってもあまり旨味がありません。根本的なところでは、そもそもの元画像の解像度がをなんとかしない限り何をやってもそれほど結果は変わらないでしょう。

というわけで、RGBでの撮影だったものに、L画像を新たに撮影して、LRGB合成にしてみたいと思います。当時はまだ5枚用のフィルターホイールを使っていて、Lで撮影する準備もできていくてLRGBに挑戦する前でした。この後のまゆ星雲ではじめて8枚用のフィルターホイールを導入し、LRGB合成に挑戦しています。

撮影日はM106の撮影が終わった3月29日。この日は前半に月が出ているのでその間はナローでHα撮影です。月が沈む0時半頃からL画像の撮影に入ります。L画像だけで合計47枚、約4時間分を撮影することができました。

ポイントはASI294MM Proで普段とは違うbin1で撮影したことでしょうか。RGBの時もbin1で撮影していますが、これはM51本体が小さいために高解像度で撮影したいからです。bin2で2倍バローを用いた時と、bin1でバローなど無しで用いた時の比較は以前M104を撮影した時に議論しています。

解像度としてはどちらも差はあまりなかったが、バローをつける時にカメラを外すことで埃が入る可能性があるので、それならばbin1の方がマシというような結論でした。

以前RGBを撮影した時は1枚あたり10分露光でしたが、今回は5分露光なので、ダーク、フラット、フラットダークは全て撮り直しになります。

画像処理は結構時間がかかってしまいました。問題はやはりLとRGBの合成です。前回のM106の撮影とその後の議論で、理屈上は何が正しいかはわかってきましたが、実際上は何が一番いいかはまだわかっていないので、今回も試行錯誤です。今回下記の6つの手順を試しました。Niwaさんや蒼月城さんが指摘されているように、LinearでのLRGB合成で恒星の色がおかしくなる可能性があるのですが、今回は際立って明るい恒星がなかったので、LinearでのLRGB合成がダメかどうかきちんと判断することができなかったのが心残りです。

ちなみに

それぞれの場合にどうなったか、結果だけ書きます。赤はダメだったこと、青は良かったことです。

というわけで、正しいと思われる4番は悪くないですが、青飛びを完全に解決できなかったことと、ストレッチの度合いがRGBとLが別だとどこまでやっていいかの判断がつきにくく、結局6番を採用しました。でもストレッチをあまりかけずにLを合成することが正しい方法なのかどうか、いまだによくわかっていません。その一方、Lab変換でabをボカしたことが青飛びを完全に回避しているので、手段としては持っておいてもいいのかもしれません。

その後、Photoshopに渡して仕上げます。分解能を出すのにものすごく苦労しました。AstrtoBinでM51を検索するとわかりますが、形の豪華さの割に、大きさとしては小さい部類のM51の分解能を出すのはなかなか大変そうなのがわかります。物凄く分解能が出ている画像が何枚かあったので「おっ!」と思ったのですが、実際にはほとんどがHubble画像の再処理でした。1枚だけHubble以外でものすごい解像度のものがありましたが、望遠鏡の情報を見たら口径1メートルのものだったのでさすがに納得です。それよりもタカsiさんが最近出したM51の解像度が尋常でないです。口径17インチなので約43cm、これでAstroBinにあった口径1メートルの画像に勝るとも劣りません。43cmでここまででるのなら、自分の口径26cmでももう少し出てもおかしくないのかと思ってしまいます。今回私の拙い技術で出せたのはこれくらいです。クロップしてあります。

元の大きさではこうなります。ただしbin1のままだと画素数が多すぎてブログにアップロードできないので、解像度を縦横半分のbin2相当にしてあります。

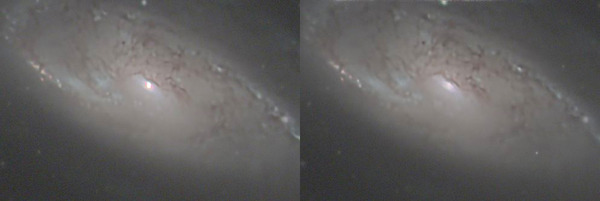

中心部を比較してみます。左が昨年のRGBだけのもの、右がL画像とHα画像を撮り増ししたものです。

見比べると、明らかに今回のL画像が入った方が分解能が増していることがわかります。ただすでに画像処理がキツすぎる気もしています。今の機材でこれ以上の分解能を求めるにはどうしたらいいのでしょうか?

考えられる改良点は、

BXTという観点からはあまり大したことは言えていません。分解能という観点からはDeNoise AIとそこまで能力は差がなさそうなことがわかりますが、恒星の収差補正などに利点があり、今後DeNoise AIを使うことはほぼなくなるでしょう。リニアなステージで使うことが正しそうで、RGBとLで別々に処理して合成しても問題なさそうなことがわかりました。BXTなしとありでは分解能に圧倒的に差が出て、今回もM51としてはそこそこの分解能になっていますが、まだ鏡筒の性能を引き出し切っているとは言い難いのかと思います。

RGBだけの場合と、Lがある場合では分解能にあからさまに差が出ることが改めてわかりました。でもなぜそこまで差が出るのか、自分自身本質的にはあまりよくわかっていません。単にLの露光時間が長いからなのか? R、G、Bとフィルターで光量が減るので、それに比べて全部の光子を拾うLが得なのか? それとも他に何か理由があるのか? 一度、R、G、B、Lを全て同じ時間撮影して、RGB合成したものからLを引き出して比較してみるのがいいのかもしれません。

とまあ色々議論したいことはありますが、庭撮りで着実に進歩はしてきていて、M51がここまで出たこと自身はある程度満足しています。でももう少し出るかと淡い期待を抱いていたことも事実です(笑)。

元々BXTで言われていた星雲部分の分解能、あまり話題になってなくて遥かに期待以上だった恒星の収差補正など、劇的な効果があります。

その一方、最近のM106の画像処理で分かったのは

- BXTで銀河中心部の飽和が起きることがある。

- BXTの恒星認識に引っかからない微恒星が小さくならなくて、恒星の明るさ位に対する大きさの逆転現象が起きる。

- 光軸調整が不十分なことから起きる恒星の歪みはBXTで補正できなくてむしろ変な形を強調してしまうことがある。

- BXTはリニア段階(ストレッチする前)で処理すべき(とBXTのマニュアルにも書いてあります)だが、LRGB合成はノンリニア(ストレッチしてから)処理すべきなので、リニアでできるRGB合成した後の段階ではBXTを使うことができるが、(額面通りに理解すると)LRGB合成した段階でBXTを使うことはできないということになる。

M106も2度処理しているのである意味再処理なのですが、BXTを使っての「過去画像の」再処理という意味では、銀河を扱うのは今回初めてになります。これまで手をつけなかったことには実は明確な理由がありますが、そこらへんも記事に書いておきました。

そう言ったことも踏まえて、今回のBXTを使った処理では何が分かったのでしょうか?

子持ち銀河

ターゲットのM51: 子持ち銀河ですが、昨年4月に自宅でSCA260を使い、ASI294MM ProのRGB撮影で総露光時間4時間半で撮影したものです。

実はM51の再処理、かなり初期の頃に手掛けています。時期的は最初のBXTでの再処理の最初の記事の三日月星雲よりも前に試しています。銀河はBXTで分解能が上がることをかなり期待していました。でも改善がほとんど見られなかったのです。

BTX導入直後くらいに一度M51の再処理を試み、その後三日月星雲とかを処理してある程度技術的にも確立してきた後に、さらに再処理してみたM51です。

同じ画角の元の画像を下に載せます。

再処理ではHαを載せていないので、派手さはないのは無視してください。2つを比較してみると、確かに少し分解能は上がったかもしれません。でも思ったほどの改善ではありませんし、むしろノイジーになるなど、悪くなっているところも見受けられます。なんでか色々考えたのですが、恐らくですが以前の処理はDeNoise AIを利用するなどかなり頑張っていて、すでにそこそこの解像度が出ていたということです。言い換えると、(今のところの結論ですが)いくらAIと言えど、画像に含まれていない情報を引き出すことは(例え処理エンジンは違っても)できないのではということです。逆に情報として含まれていないものを飛び抜けて出したとしたら、それは流石にフェイクということになります。

BTXとDeNoise AIを比べてみると、DeNoise AIの方が(天体に特化していないせいか)大きくパラメータを変えることができるので、おかしくなるように見えると思われがちですが、おかしくならない程度に適用する分には、BXTもDeNoise AIもそこまで差がないように思いました。DeNoise AIはノイズ除去と共にSharpen効果もあるのですが、BXTはノイズについてはいじることはないので、DeNoise AI = NoiseXTerminator + BlurXTerminatorという感じです。

それでは、DeNoise AIではなくBlurXTerminatorを使う利点はどこにあるのでしょうか?最も違うところは、恒星の扱いでしょう。DeNoise AIは恒星ありの画像は確実に恒星を劣化させるので、背景のみにしか適用できないと思っていいでしょう。その一方、BlurXTerminatorはAIと言っても流石にdeconvolutioinがベースなだけあります。星像を小さくする効果、歪みをかなりのレベルで補正してくれる効果は、BlurXTerminatorの独壇場です。恒星を分離した背景のみ、もしくは恒星をマスクした背景のみの構造出しならDeNosie AIでもよく、むしろノイズも同時に除去してくれるので時には便利ですが、やはり恒星をそのままに背景の処理をできるBXTとNXTの方が手間が少なく恒星のダメージも全然少ないため、天体写真の処理に関して言えばもうDeNoise AIを使うことはほとんどなくなるのかと思います。

L画像を追加してLRGBに

さて、上の結果を見るとこのままの状態でBXTを使ってもあまり旨味がありません。根本的なところでは、そもそもの元画像の解像度がをなんとかしない限り何をやってもそれほど結果は変わらないでしょう。

というわけで、RGBでの撮影だったものに、L画像を新たに撮影して、LRGB合成にしてみたいと思います。当時はまだ5枚用のフィルターホイールを使っていて、Lで撮影する準備もできていくてLRGBに挑戦する前でした。この後のまゆ星雲ではじめて8枚用のフィルターホイールを導入し、LRGB合成に挑戦しています。

撮影日はM106の撮影が終わった3月29日。この日は前半に月が出ているのでその間はナローでHα撮影です。月が沈む0時半頃からL画像の撮影に入ります。L画像だけで合計47枚、約4時間分を撮影することができました。

ポイントはASI294MM Proで普段とは違うbin1で撮影したことでしょうか。RGBの時もbin1で撮影していますが、これはM51本体が小さいために高解像度で撮影したいからです。bin2で2倍バローを用いた時と、bin1でバローなど無しで用いた時の比較は以前M104を撮影した時に議論しています。

解像度としてはどちらも差はあまりなかったが、バローをつける時にカメラを外すことで埃が入る可能性があるので、それならばbin1の方がマシというような結論でした。

以前RGBを撮影した時は1枚あたり10分露光でしたが、今回は5分露光なので、ダーク、フラット、フラットダークは全て撮り直しになります。

画像処理

画像処理は結構時間がかかってしまいました。問題はやはりLとRGBの合成です。前回のM106の撮影とその後の議論で、理屈上は何が正しいかはわかってきましたが、実際上は何が一番いいかはまだわかっていないので、今回も試行錯誤です。今回下記の6つの手順を試しました。Niwaさんや蒼月城さんが指摘されているように、LinearでのLRGB合成で恒星の色がおかしくなる可能性があるのですが、今回は際立って明るい恒星がなかったので、LinearでのLRGB合成がダメかどうかきちんと判断することができなかったのが心残りです。

- RGBもL画像もLinear状態で、LRGB合成をしてからBXT。

- RGBもL画像もLinear状態で、BXTをしてからLRGB合成。

- RGBもL画像もLinear状態で、だいこもんさんがみつけたLinLRGBを使い、HSI変換のうちIとL画像を交換。

- RGBとL画像とLinear状態でBXTまでしてから、フルストレッチしてNon Linear状態にしてからLRGB合成。

- RGBとL画像とLinear状態でBXTまでしてから、フルストレッチしてNon Linear状態にしてからLab変換して、aとbをconvolutionでStdDev=5でぼかしてからLab合成。

- RGBとL画像とLinear状態でBXTまでしてから、少しだけストレッチしてLinearに近いNon Linear状態にしてからLab変換して、aとbをconvolutionでStdDev=5でぼかしてからLab合成。

ちなみに

- BXTはリニアで使うべし。

- LRGBはノンリニアで使うべし。

- WBPP -> ABE or DBE -> RGB合成 -> RGB画像にSPCC -> RGB画像、L画像それぞれにBXT -> ストレッチ -> LRGB合成

それぞれの場合にどうなったか、結果だけ書きます。赤はダメだったこと、青は良かったことです。

- 星雲の明るい部分に青飛びが見られた。(極端に明るい恒星はなかったので)恒星などの飛びは見られなかった。LRGB合成した後でBXTをかけるので、本来恒星が小さくなると期待したが、うまく小さくならず、変な形のものが残った。

- 星雲の明るい部分に青飛びが見られた。(極端に明るい恒星はなかったので)恒星などの飛びは見られなかった。1に比べて恒星が明らかに小さくなった。

- 星雲の明るい部分に青飛びが見られた。(極端に明るい恒星はなかったので)恒星などの飛びは見られなかった。1に比べて恒星が明らかに小さくなった。ちなみに、LinLRGBはPixInsightに標準で組み込まれているものではなく、Hartmut Bornemann氏が作ったもので、ここにインストールの仕方の説明があります。

- 青飛びが少し改善した。1に比べて恒星が明らかに小さくなった。ただし最初にストレッチしすぎたせいか、解像度があまり出なかった。

- 青飛びが無くなった。1に比べて恒星が明らかに小さくなった。ただし最初にストレッチしすぎたせいか、解像度があまり出なかった。

- 青飛びが無くなった。1に比べて恒星が明らかに小さくなった。ストレッチしすぎてなかったせいか、一番解像度が出た。

というわけで、正しいと思われる4番は悪くないですが、青飛びを完全に解決できなかったことと、ストレッチの度合いがRGBとLが別だとどこまでやっていいかの判断がつきにくく、結局6番を採用しました。でもストレッチをあまりかけずにLを合成することが正しい方法なのかどうか、いまだによくわかっていません。その一方、Lab変換でabをボカしたことが青飛びを完全に回避しているので、手段としては持っておいてもいいのかもしれません。

仕上げ

その後、Photoshopに渡して仕上げます。分解能を出すのにものすごく苦労しました。AstrtoBinでM51を検索するとわかりますが、形の豪華さの割に、大きさとしては小さい部類のM51の分解能を出すのはなかなか大変そうなのがわかります。物凄く分解能が出ている画像が何枚かあったので「おっ!」と思ったのですが、実際にはほとんどがHubble画像の再処理でした。1枚だけHubble以外でものすごい解像度のものがありましたが、望遠鏡の情報を見たら口径1メートルのものだったのでさすがに納得です。それよりもタカsiさんが最近出したM51の解像度が尋常でないです。口径17インチなので約43cm、これでAstroBinにあった口径1メートルの画像に勝るとも劣りません。43cmでここまででるのなら、自分の口径26cmでももう少し出てもおかしくないのかと思ってしまいます。今回私の拙い技術で出せたのはこれくらいです。クロップしてあります。

「M51:子持ち銀河」

- 撮影日: RGB: 2022年4月2日20時32分-4月3日3時50分、LとHa: 2023年3月29日20時17分-3月30日4時34分

- 撮影場所: 富山県富山市自宅

- 鏡筒: SHARP STAR製 SCA260(f1300mm)

- フィルター: Baader RGB、Hα

- 赤道儀: Celestron CGX-L

- カメラ: ZWO ASI294MM Pro (-10℃)

- ガイド: f120mmガイド鏡 + ASI290MM、PHD2によるマルチスターガイドでディザリング

- 撮影: NINA、Gain 240で露光時間10分がR: 7枚、G: 7枚、B: 10枚、Gain 240で露光時間5分がL: 47枚、Hα: 21枚の計27枚で総露光時間240+340 =580分 =9時間40分

- Dark: Gain 240で露光時間10分が64枚、Gain 240で露光時間5分が128枚

- Flat, Darkflat: Gain 240で露光時間 RGB: 0.03秒、L: 0.01秒、Hα: 0.2秒、 RGBがそれぞれ64枚、LとHαがそれぞれ128枚

- 画像処理: PixInsight、Photoshop CC

元の大きさではこうなります。ただしbin1のままだと画素数が多すぎてブログにアップロードできないので、解像度を縦横半分のbin2相当にしてあります。

中心部を比較してみます。左が昨年のRGBだけのもの、右がL画像とHα画像を撮り増ししたものです。

見比べると、明らかに今回のL画像が入った方が分解能が増していることがわかります。ただすでに画像処理がキツすぎる気もしています。今の機材でこれ以上の分解能を求めるにはどうしたらいいのでしょうか?

考えられる改良点は、

- シーイングのいい時に撮影する。

- Lがフィルター無しなので、UV/IRカットフィルターを入れて赤外のハロなどをなくす。

- 振動が問題になる可能性があるので、三脚の足に防震シートなどを入れる。

- 読み出しノイズに制限されているわけではなさそうなので、揺れ対策で1枚あたりの露光時間を3分ほどにしてみる。

- Lの総露光時間をもっと増やす。

- 暗い空で撮影する。

- バローを入れて焦点距離を伸ばし、かつbin1で撮影する。

まとめ

BXTという観点からはあまり大したことは言えていません。分解能という観点からはDeNoise AIとそこまで能力は差がなさそうなことがわかりますが、恒星の収差補正などに利点があり、今後DeNoise AIを使うことはほぼなくなるでしょう。リニアなステージで使うことが正しそうで、RGBとLで別々に処理して合成しても問題なさそうなことがわかりました。BXTなしとありでは分解能に圧倒的に差が出て、今回もM51としてはそこそこの分解能になっていますが、まだ鏡筒の性能を引き出し切っているとは言い難いのかと思います。

RGBだけの場合と、Lがある場合では分解能にあからさまに差が出ることが改めてわかりました。でもなぜそこまで差が出るのか、自分自身本質的にはあまりよくわかっていません。単にLの露光時間が長いからなのか? R、G、Bとフィルターで光量が減るので、それに比べて全部の光子を拾うLが得なのか? それとも他に何か理由があるのか? 一度、R、G、B、Lを全て同じ時間撮影して、RGB合成したものからLを引き出して比較してみるのがいいのかもしれません。

とまあ色々議論したいことはありますが、庭撮りで着実に進歩はしてきていて、M51がここまで出たこと自身はある程度満足しています。でももう少し出るかと淡い期待を抱いていたことも事実です(笑)。